Czym jest i jak działa Google bot? Roboty internetowe, w tym Googlebot, mimo że dla przeciętnego użytkownika internetu pozostają niewidoczne, a ich aktywność w świadomości wielu userów okazuje się niezauważona, mają jednak znaczący wpływ na to, co finalnie znajdujemy w sieci. To właśnie roboty Google odpowiadają za dane, które za pomocą konkretnych zapytań jesteśmy w stanie uzyskać w wyszukiwarkach internetowych takich jak Google.

Czym tak właściwie jest Googlebot?

Spośród wielu robotów internetowych, które każdego dnia poruszają się po miliardach stron internetowych, można wymienić właśnie Googlebota. Jest to specjalny program służący do skanowania poszczególnych witryn i gromadzenia określonych danych na temat odwiedzanych serwisów. W zależności od przeznaczenia robotów internetowych wyróżnia się m.in.:

- boty komercyjne wykorzystywane w marketingu cyfrowym;

- boty monitorujące poprawność działania stron internetowych;

- tzw. feed fetcher, czyli bot zbierający wiadomości ze stron do wyświetlania w aplikacjach mobilnych;

- roboty indeksujące.

W tym artykule skupiamy się właśnie na robotach indeksujących, które skanują sieć dla wyszukiwarek. Ich zadaniem jest przede wszystkim zbieranie informacji o danej stronie internetowej, sprawdzanie treści i pozostałej zawartości witryny, badanie kodu oraz monitorowanie aktualizacji.

Wyróżniamy dwa główne rodzaje robotów Google:

- Googlebot Mobile – symuluje ruch użytkownika na stronie internetowej z poziomu urządzenia mobilnego;

- Googlebot Desktop – symuluje ruch użytkownika z poziomu komputera stacjonarnego lub laptopa.

W jaki sposób działa Googlebot?

Roboty Google są odpowiedzialne za indeksowanie stron internetowych. Poruszając się za pomocą linków, robot odwiedza kolejne witryny, skanuje ich zawartość i umieszczone w ich obrębie treści, a następnie wszystkie zgromadzone dane przesyła dalej. Na podstawie tych informacji algorytm Google w dalszej kolejności decyduje o tym, jakie strony mają zostać wyświetlone użytkownikowi po wpisaniu przez niego określonej frazy w wyszukiwarkę.

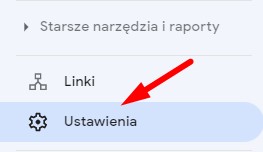

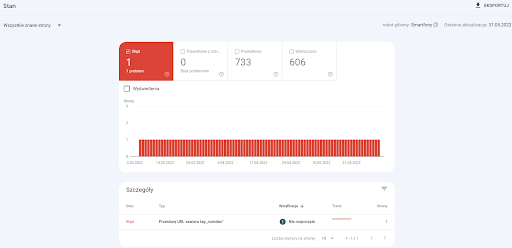

Odwiedzając daną stronę internetową, Googlebot posiada określony crawl budget, czyli ilość czasu, którą może poświęcić na skanowanie zasobów serwisu. Crawl budget powinien być odpowiednio zoptymalizowany tak, aby maksymalnie wykorzystać czas, w którym robot porusza się w obrębie serwisu. Poprawna optymalizacja witryny sprawi, że robot Google będzie indeksował tylko te strony, które są rzeczywiście istotne. Sam Crawl Budget jest mocno powiązany z PageSpeed, czyli prędkością ładowania strony. Więcej na ten temat dowiecie się z artykułu – Dlaczego optymalizacja prędkości ładowania ma znaczenie w SEO? Warto regularnie monitorować statystyki dotyczące ruchu robotów na stronie, które dostępne są np. w narzędziu Google Search Console:

Dlaczego roboty Google są istotne pod kątem SEO?

Google jest najpopularniejszą wyszukiwarką na świecie, o czym świadczy fakt, że korzysta z niej 92% użytkowników na świecie i aż 96% w samej Polsce. Oznacza to jednocześnie, że to właśnie z tej wyszukiwarki pochodzi zdecydowana większość ruchu organicznego, co powoduje, że optymalizacja stron dostosowywana jest przede wszystkim do wymagań Google i jego robotów indeksujących.

Roboty Google mają ogromne znaczenie dla działań SEO. Okazuje się bowiem, że to Googlebot i związany z nim proces indeksowania sprawia, że dana witryna internetowa jest widoczna i często odwiedzana. Aby poszczególni użytkownicy mogli trafić na stronę, Google musi uprzednio zebrać wystarczającą ilość danych na temat danej witryny, jej treści, tematyki i zasobów. Zadanie to umożliwia właśnie wspomniany Googlebot, który jest odpowiedzialny za gromadzenie danych, które są zapisywane w indeksie. Następnie algorytm Google – zgodnie z wytycznymi – dopasowuje najtrafniejsze strony do zapytań użytkowników wpisywanych w wyszukiwarkę.

Jak zoptymalizować ruch robotów indeksujących na stronie?

Można wskazać kilka sprawdzonych sposobów na to, aby lepiej pokierować ruchem robotów indeksujących w serwisie, a tym samym ułatwić Googlebotowi indeksację strony i znacząco usprawnić cały proces.

Mapa witryny (sitemap)

Poprawnie zbudowana mapa strony to bardzo istotny element w procesie optymalizacji, który stanowi skuteczny sposób na usprawnienie pracy Googlebota. Prawidłowo przygotowana mapa witryny powinna zawierać wyłącznie te podstrony, które są dla nas istotne i wartościowe. Dzięki temu ułatwimy robotom indeksującym poruszanie się w obrębie witryny i indeksowanie tylko tych stron, które chcemy, by pojawiły się na czele wyników wyszukiwania Google. Dobrą praktyką jest ponadto zadbanie o to, by zarówno grafiki, jak i strony posiadały osobne mapy.

Odpowiednio zoptymalizowane linkowanie wewnętrzne

Kolejnym elementem, który skutecznie ułatwia poruszanie się robotom indeksującym po stronie i znacznie przyspiesza segregowanie witryn, okazują się prawidłowo rozmieszczone linki wewnętrzne w obrębie całego serwisu. To z kolei wyraźnie zwiększa szansę na poprawne zaindeksowanie się większej liczby podstron, co jest niezwykle istotne z punktu widzenia SEO.

Stosowanie linków kanonicznych

Linki kanoniczne, czyli canonicale, wykorzystuje się po to, by wskazać Googlebotowi właściwe wersje zduplikowanych lub bardzo podobnych do siebie stron. Identyczne lub w dużej części zbieżne ze sobą strony, które znajdują się pod kilkoma różnymi adresami URL, nie tylko dezorientują roboty indeksujące Google, ale również marnują crawl budget, przez co spowalniają indeksowanie strony internetowej.

Odpowiednio zoptymalizowane treści

Aktualnie Googlebot najlepiej radzi sobie z czytaniem tekstu, dlatego należy mieć to na uwadze, przygotowując treści do serwisu. Roboty indeksujące potrafią odczytywać również grafiki czy materiały wideo, jednak nie w tak zaawansowanym stopniu jak tekst. Z tego powodu rekomendowaną praktyką jest uzupełnianie umieszczanych na stronie grafik odpowiednio zoptymalizowanymi tytułami oraz poprawnie sformułowanymi atrybutami ALT. Warto zaznaczyć, że robot Google może mieć pewne trudności z poprawnym odczytaniem treści umieszczonej w Ajax lub JavaSvript. Dlatego decydując się na takie rozwiązanie, należy upewnić się, że robot poprawnie renderuje taką treść.

Należy pamiętać również o tym, że wartościowa, merytoryczna i bogata we frazy kluczowe treść stanowi jeden z kluczowych czynników rankingowych, na podstawie których algorytm Google wyświetla strony w wynikach wyszukiwania Google. Z tego powodu warto dbać zarówno o regularne dodawanie nowych, użytecznych dla odbiorców treści, jak i o aktualizowanie raz na jakiś czas tych już opublikowanych w serwisie. Okazuje się bowiem, że Googlebot zwraca uwagę także na to, czy strona jest często aktualizowana i takie premiuje.

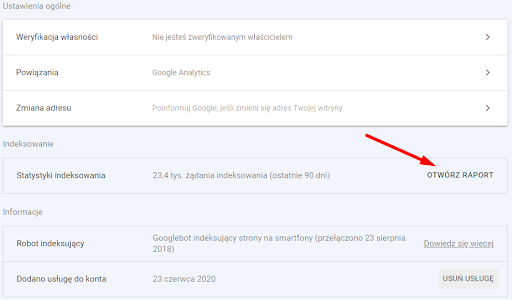

Robots.txt, czyli instrukcje dla robotów

Plik robots.txt to jedna z pierwszych rzeczy, których szuka robot Google po wejściu na stronę internetową, dlatego należy szczególnie zadbać o umieszczenie w nim odpowiednich instrukcji. Robots.txt to bowiem bardzo ważny element, ponieważ pozwala zablokować dostęp do podstron, które są nieistotne z punktu widzenia SEO, a tym samym umożliwia optymalizację crawl budgetu.

Należy pamiętać, że Googlebot zazwyczaj postępuje zgodnie z instrukcjami zawartymi robots.txt, jednak zdarzają się pewne wyjątki od tej reguły. Dlatego warto również stosować pomocne atrybuty „noindex” oraz „nofollow” w tagu metarobots na podstronach, które nie powinny być indeksowane przez roboty. Co istotne, w robots.txt istnieje możliwość rozpisania instrukcji dla różnych robotów. W związku z tym można np. zablokować dostęp Googlebota do niektórych stron, ale jednocześnie zezwalać na ruch w obrębie całego serwisu botom powiązanym z narzędziami takimi jak Ahrefs.

Atrybuty linków oraz w kodzie

Wspomniany wyżej atrybut „noindex” umieszcza się w kodzie w celu polecenia robotom, by nie indeksowały danej strony. Z kolei za pomocą atrybutu „nofollow” możliwe jest wskazanie robotom Google, aby nie odwiedzały opatrzonej nim strony. Przykład:

<meta name=”robots” content=”noindex, nofollow”>

Umieszczając w kodzie powyższy atrybut, sprawimy, że robot nie będzie indeksował ani odwiedzał tak oznaczonej strony.

Natomiast z pomocą atrybutu rel=”nofollow” warto oznaczać linki, w które bot nie powinien wchodzić. Atrybut ten powoduje bowiem, że robot omija taki link, kiedy trafi na niego podczas skanowania danej strony. Dobrą praktyką jest stosowanie tego atrybutu przy linkach wychodzących z witryny, np. odsyłających do profili w social media. Przykład:

<a href=”https://www.facebook.com/agencjaseosemstrategiczni/” rel=”nofollow”>

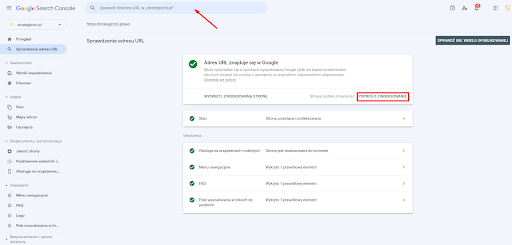

W celu zweryfikowania, czy strona internetowa jest poprawnie indeksowana, warto skorzystać z Google Search Console. Narzędzie to pozwala sprawdzić, czy robot napotyka na jakieś błędy lub problemy z indeksacją strony. Szczegółowy raport na ten temat można znaleźć w GSC w sekcji „Indeks”, w zakładce „Stan”:

Ponadto w Google Search Console możemy sprawdzić, czy poszczególne adresy URL z naszego serwisu zostały prawidłowo zaindeksowane przez Googlebota. Aby to zrobić, wystarczy wkleić interesujący nas adres w pole znajdujące się u samej góry głównego widoku narzędzia. Jeśli adres nie znajduje się w indeksie, wówczas możemy ręcznie poprosić o jego dodanie, klikając pole „Poproś o zaindeksowanie”. Należy mieć przy tym na uwadze, że nie zawsze robot Google zaindeksuje wskazaną stronę za pierwszym razem, dlatego warto ponawiać tę prośbę co kilka dni, aż do skutku.

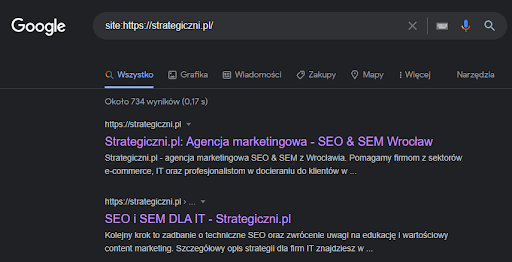

Aby sprawdzić zaindeksowane strony w naszym serwisie, możemy użyć również komendy „site” bezpośrednio w wyszukiwarce:

Dlaczego Googlebot nie indeksuje strony?

Najczęstszymi przyczynami takiego stanu rzeczy okazują się:

- niewłaściwie skonfigurowany plik robots.txt blokujący dostęp do części strony internetowej;

- zastosowanie tagu „noindex” – zdarza się, że deweloper podczas publikacji strony zapomina o usunięciu tego tagu z kodu, co w konsekwencji prowadzi do sytuacji, w której roboty nie mogą zaindeksować strony;

- stosunkowo nowa strona, której roboty jeszcze nie zdążyły zauważyć;

- brak linków zewnętrznych odsyłających do strony, co jest utrudnieniem dla Googlebota w znalezieniu takiej witryny (w celu ułatwienia tego zadania robotom warto przy publikacji strony zadbać o przynajmniej kilka linków zewnętrznych, np. z artykułów sponsorowanych w popularnych serwisach);

- błędy po stronie serwera (np. serwer jest przeciążony lub upłynął limit czasu oczekiwania na odpowiedź serwera);

- strona została usunięta z indeksu za naruszenie wytycznych Google.

Podsumowanie

Odpowiednia optymalizacja pod kątem robotów Google ma istotne znaczenie dla procesu pozycjonowania strony internetowej. To właśnie algorytmy Google wpływają bowiem na to, co finalnie użytkownicy znajdują w sieci, dostosowując wyniki wyszukiwania do konkretnych zapytań. Poprawnie zoptymalizowana witryna pozwala właściwie pokierować ruchem robotów Google, oszczędzając cenne zasoby, w tym crawl budget.

Jako Strategiczni.pl możemy sprawdzić, czy Twoja strona jest widoczna dla robotów indeksujących i nie tylko! Przygotujemy dla Ciebie kompleksowy audyt SEO, w którym zidentyfikujemy błędy na Twojej stronie i wskażemy optymalny kierunek poprawek i zmian prowadzących do wzmocnienia Twojego serwisu w organicznych wynikach wyszukiwania! Masz pytania? Skontaktuj się z nami!

Sprawdź naszą ofertę!

Autor

Autor

Komentarze (0)